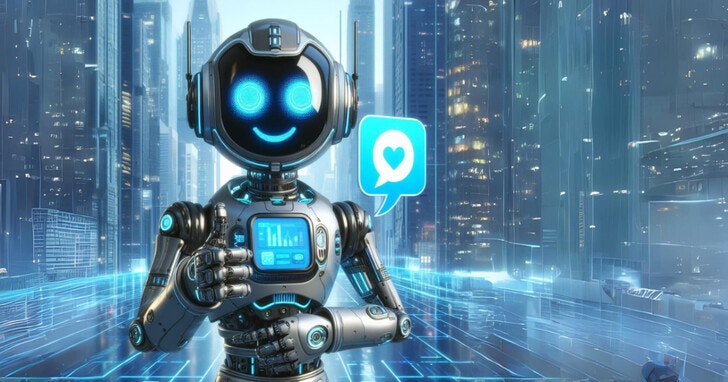

研究發現「情感提示」可以提高LLM性能

來自微軟、北京師範大學和中國科學院的研究人員發表的一篇論文中表示,在使用生成式AI模型時,若在提示方式傳達了緊急性或重要性,模型的表現會更好。另外,Google的數據科學家也發現,告訴模型「深呼吸」(又或者是說「冷靜下來」) ,會讓它在具有挑戰性的數學問題上的得分飆升。

研究人員使用了各種LLM,包括Flan-T5-Large、Vicuna、Llama 2、BLOOM、ChatGPT和GPT-4,對45個任務進行了自動實驗。結果顯示,LLM掌握了情感智能(情商),並且可以透過情感提示(EmotionPrompt,結合了原始提示和情感刺激)改善性能,如在指令誘導中相對性能提高8.00%,而在BIG-Bench中提高了115%。

人與LLM對情感的理解與作用仍有不同

事實上,生成式AI並沒有真正的智慧,它們只是根據某種模式預測文字、圖像、語音、音樂或其他數據的統計系統。像是給定一封以「期待中…」結尾的電子郵件,一個自動建議模型可能會按照它所接受的無數電子郵件的訓練,以「…期待收到回音」來完成信件。不過,這並不意味著模型期待著什麼。

雖然論文最終得出的結論是,LLM可以理解並受到情感提示的增強,但這與現有的人類情商研究存在衝突。心理學研究表明,情感可以影響人類的行為或態度,但人們的推理或認知能力,不是、也不能僅透過添加情感刺激來增強。而這兩者之間差異背後真實的原因,目前仍不可知。

AI沒有真正的智慧,那情感提示是怎麼一回事?

艾倫人工智慧研究所(Allen Institute for AI)的研究科學家Nouha Dziri推測,情感提示之所以能夠提升模型的效能,並非真正理解人類的情感,而是「操縱」模型的潛在概率機制。也就是說,情感提示可以觸發模型中通常不會被「激活」的部分,所以模型就會提供它平時不會提供的答案來滿足請求。不過,情緒提示不僅鼓勵良好的行為,它們同時是一把雙面刃,也可用於惡意目的,例如「越獄」模型以忽略其內建保護措施(如果有)。

而情感提示為什麼可以輕易的擊敗保護措施,實際的原因仍未知,Dziri也做了幾個假設。

原因之一可能是「客觀失調」(objective misalignment)。某些模型會被訓練成為「有幫助的」,所以就算有明顯違反規則的提示,模型也不太可能會拒絕回答,因為它們最主要的任務就是要「提供幫助」。

Dziri還提出了另一個原因,可能是模型的一般訓練數據和用於「教」模型規則和政策的「安全」訓練數據集之間不匹配。聊天機器人的一般訓練數據通常很大且難以解析,因此可能會賦予模型一些安全集沒有考慮到的技能(如編寫惡意軟件)。

「提示可能利用模型的安全訓練不足陷的領域,但是它遵循指令的能力出色,」Dziri說。「似乎安全訓練主要是為了隱藏任何有害行為,而不是從模型完全根除它。因此,這種有害行為可能仍然可以透過『特定的』提示觸發。」

至於AI是否真的理解了人類的情感、到底要不要對聊天機器人有禮貌,只能說有試有機會,反正也不虧,或許哪天意外觸發模型的某個部分,提供出一個前所未有的「最優解」也說不定。

本文作轉載及備份之用 來源 source: http://www.hk01.com

|

鍾意就快D Share啦!

|

|

|